Black Hat SEO bezeichnet unethische oder gegen die Richtlinien von Suchmaschinen verstoßende Methoden zur Manipulation von Suchergebnissen. Ziel ist/war es, schnell hohe Rankings zu erzielen, oft auf Kosten der Benutzererfahrung oder durch Täuschung der Suchmaschinen-Algorithmen.

Inhaltsverzeichnis

Historische Einordnung in SEO

In den frühen Tagen des Internets, insbesondere in den 1990er- und frühen 2000er-Jahren, war SEO noch ein regelrechtes Wildwest-Gebiet. Suchmaschinen wie Altavista, Yahoo und die frühen Versionen von Google nutzten vergleichsweise einfache Algorithmen, die sich leicht manipulieren ließen.

Black Hat SEO-Techniken (siehe unten) wie Keyword Stuffing, versteckte Texte oder massenhafter Linkaufbau funktionierten damals hervorragend, da Suchmaschinen vor allem auf Keyword-Dichte und Linkanzahl achteten, ohne dabei die Qualität der Inhalte zu bewerten. Webseiten konnten sich mit minimalem Aufwand in den Rankings nach oben katapultieren.

Mit der Weiterentwicklung der Suchmaschinen – insbesondere durch Google – wurde Black Hat SEO jedoch zunehmend schwieriger und riskanter. Meilensteine waren:

- 2003: Google Florida Update – Erste größere Maßnahmen gegen Keyword Stuffing und manipulative Links.

- 2011: Google Panda Update – Qualitätsbewertung von Inhalten wurde wichtiger, minderwertige oder automatisch generierte Inhalte wurden abgestraft.

- 2012: Google Penguin Update – Kampf gegen unnatürlichen Linkaufbau, Linkfarmen und übermäßiges Keyword-Stuffing.

- 2019: Google BERT Update – Künstliche Intelligenz hilft Google, Inhalte besser zu verstehen und nutzerorientierte Suchergebnisse zu liefern.

Bezug zu aktuellen SEO-Empfehlungen

Moderne SEO-Strategien setzen auf White Hat SEO, also auf nachhaltige, qualitativ hochwertige Optimierungsmethoden, die den Richtlinien von Google entsprechen. Während früher Black Hat Techniken noch kurzfristige Erfolge bringen konnten, ist das heute riskant und oft nutzlos.

Heute gilt:

✅ Hochwertiger Content mit echtem Mehrwert für Nutzer ist der wichtigste Ranking-Faktor.

✅ Natürliches Linkbuilding ist besser als gekaufte oder massenhaft gesetzte Backlinks.

✅ Technisches SEO bleibt relevant, aber ohne Manipulation (z. B. durch Cloaking).

✅ User Experience, Ladezeiten und mobile Optimierung sind entscheidend für die Sichtbarkeit.

✅ Künstliche Intelligenz (Google RankBrain, BERT, MUM) sorgt dafür, dass semantisch sinnvolle Inhalte besser ranken als plumpes Keyword-Stuffing.

❗ ❗ ❗ Heute ist Blackkhat SEO ein hochriskanter und ineffektiver Ansatz. Aktuelle SEO-Empfehlungen setzen auf hochwertige Inhalte, Nutzerfreundlichkeit und technische Sauberkeit, während manipulative Methoden schnell zu Abstrafungen führen.

Konsequenzen von Black Hat SEO

Die Konsequenzen von Black Hat SEO können gravierend sein, da Suchmaschinen wie Google gezielt gegen Manipulationsversuche vorgehen. Hier sind die möglichen Folgen:

- Ranking-Verlust: Google erkennt unnatürliche SEO-Techniken und stuft die betroffene Website im Ranking herab, oft drastisch. Eine Seite, die vorher auf Platz 1 war, kann auf Seite 5 oder noch weiter abrutschen.

- Manuelle Abstrafung (Google Penalty): Die Website kann von Google eine manuelle Strafe erhalten, sodass sie für bestimmte oder sogar alle Suchbegriffe massiv an Sichtbarkeit verliert.

- De-Indexierung: In extremen Fällen entfernt Google die gesamte Website aus dem Index, sodass sie überhaupt nicht mehr über die Suchmaschine gefunden wird.

- Schlechter Ruf: Webseiten, die durch Spam-Methoden oder irreführende Inhalte auffallen, verlieren das Vertrauen der Nutzer. Ein schlechter Ruf kann langfristig die Marke oder das Unternehmen schädigen.

- Finanzielle Verluste: Da weniger Traffic über Suchmaschinen kommt, können Einnahmen aus Online-Shops, Werbeanzeigen oder anderen digitalen Geschäftsmodellen drastisch einbrechen.

- Hoher Aufwand zur Wiederherstellung: Wer von Google abgestraft wurde, muss oft viel Zeit und Geld investieren, um den Schaden zu reparieren – z. B. durch das Entfernen schlechter Links oder das Ersetzen manipulativer Inhalte durch hochwertige Texte.

- Negative Auswirkungen auf Partnerseiten: Falls eine Website in ein Linkfarm-Netzwerk oder eine andere Black-Hat-Strategie verwickelt ist, könnten auch verlinkte Seiten in Mitleidenschaft gezogen werden.

Black Hat SEO-Techniken

Keyword Stuffing

Hierbei wird ein bestimmtes Keyword so häufig in einen Text eingebaut, dass der Lesefluss unnatürlich wirkt und der Inhalt kaum Mehrwert bietet – beispielsweise: „Unsere Pizza in Berlin ist die beste Pizza in Berlin, denn wer Pizza in Berlin liebt, wird unsere Pizza in Berlin genießen.“

Doorway Pages

Das sind speziell optimierte Seiten, die nur dazu dienen, in den Suchergebnissen gut zu ranken, den Besucher aber direkt auf eine ganz andere (oft weniger relevante) Seite weiterleiten.

Link Farming

Bei dieser Technik wird ein Netzwerk aus minderwertigen Webseiten aufgebaut, die sich gegenseitig verlinken, um die Anzahl der Backlinks künstlich zu erhöhen und damit das Ranking zu manipulieren.

Unsichtbarer Text

Hier werden Keywords oder Links in einer Farbe dargestellt, die mit dem Hintergrund übereinstimmt, sodass sie für den Nutzer nicht sichtbar sind, aber von Suchmaschinen ausgelesen werden.

Automatisch generierte Inhalte

Manche Webseiten setzen auf maschinell erstellte Texte, die aus zufälligen oder aus anderen Quellen kopierten Inhalten bestehen, jedoch weder lesenswert noch nützlich für den Nutzer sind.

Negative SEO

Dabei versuchen Konkurrenten, das Ranking einer anderen Website zu sabotieren, indem sie beispielsweise massenhaft minderwertige oder Spam-Links darauf setzen, um eine Google-Abstrafung zu provozieren.

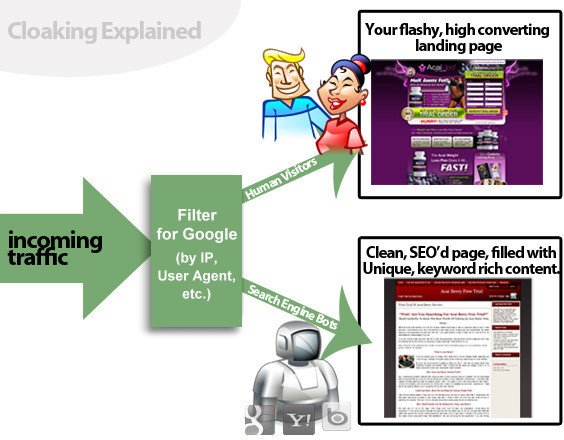

Cloaking

- cloak = Mantel, cloaking = verhüllen

- kommt eine Anfrage von einer bestimmten IP-Adresse (z.B. 231.258.476.13) oder User-Agent (z.B. GoogleBot), wird ein anderer Inhalt ausgegeben als für nicht festgelegte User (z.B andere Spider, normale User)

- Webcrawlern von Suchmaschinen werden unter der gleichen URL andere Inhalte dargeboten als dem normalen Seitenbesucher.

Wie funktioniert Cloaking?

- Modifikation in der .htaccess: mittels mod_rewrite

- Abfrage des HTTP_USER_AGENT = User Agent Cloaking

- Abrage der IP = IP Cloaking

Was sagt Google zu Cloaking?

- Usern wird anderer Content präsentiert, als ihn Googlebot sieht.

- Dies steht nicht im Einklang mit unseren Richtlinien für Webmaster.

- Wenn die Datei, die Googlebot crawlt, nicht identisch mit der Datei ist, die ein gewöhnlicher User sieht, kann das als Problem eingestuft werden.

- Cloaking ist eine Black-Hat-Methode.

- Cloaking ist niemals gut. Es gibt kein White-Hat-Cloaking.

- Früher oder später kommt es raus – und dann bekommt die Seite eine Abstrafung.

- https://webmaster-de.googleblog.com/2011/11/was-ist-cloaking.html

Wie untersucht man, ob Cloaking vorliegt?

- Abruf von Testseiten im Google-Cache (cache:beispielurl.tld/bla/blubb.html) und das Ergebnis mit der Live-Seite vergleichen, die menschlichen Benutzern angezeigt wird

- Abruf wie durch Google & Rendern, und auch mit der Live-Seite vergleichen

- Wird ein anderer Inhalt angezeigt?

- Wird eine URL (anders) weitergleitet?

- Wird ein User weitergeleitet, der bspw. über die Google-Suche oder bestimmte IP-Adresse auf die Website gekommen ist?

Risiken

- Google kann den Betrug erkennen und daraufhin betroffene Seiten abstrafen oder ganz aus dem Index entfernen

- Auch bei Hacking-Angriffen verwenden Hacker häufig Cloaking, damit der Angriff für den Website-Inhaber schwieriger zu entdecken ist.